Mixed Reality ist das Thema des diesjährigen „Capstone Projektes“. Seit einigen Jahren ist Inwerken hier als Projektsponsor aktiv. Bereits zahlreiche zukunftsweisende Projekte wurden mit der North Dakota State University (NDSU) umgesetzt. Aus dem breiten Spektrum der möglichen Anwendungsgebiete von Mixed Reality fokussierte sich das Team aus Studierenden und Azubis auf das Thema Industrial IoT – eKanban.

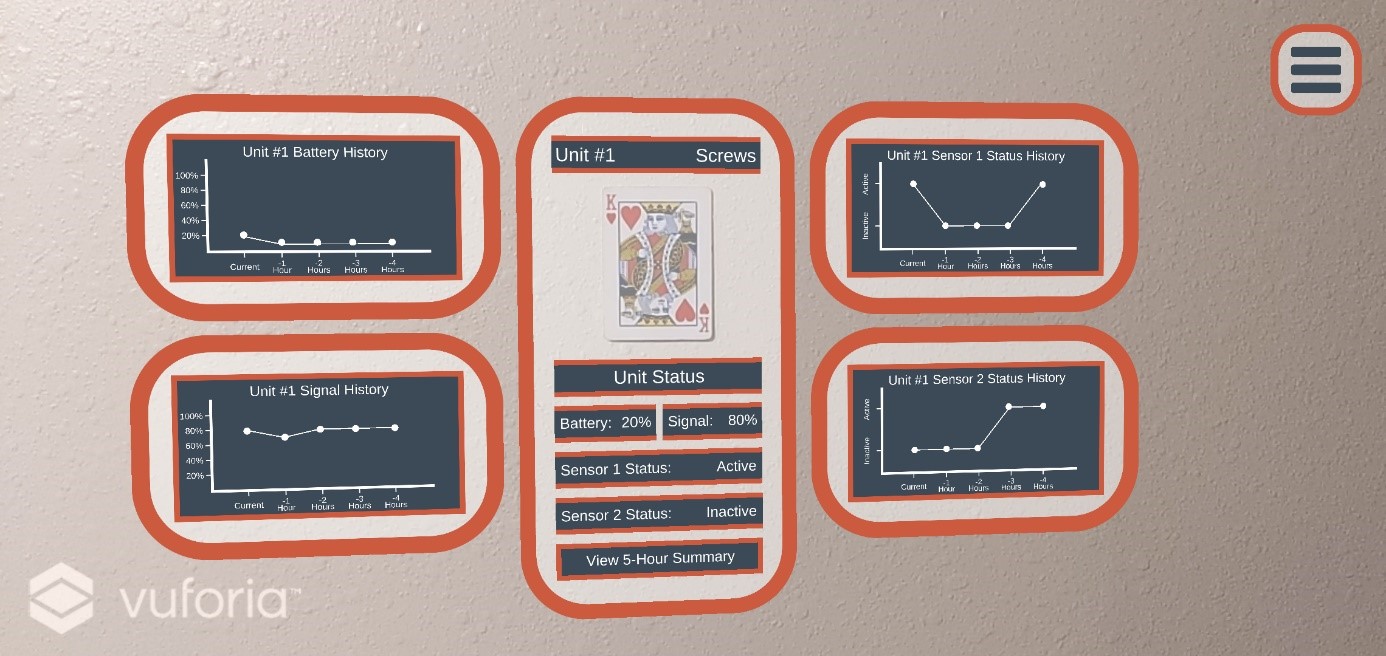

Das Ziel: Bei der Betrachtung eines IoT-Gerätes soll die Sensorinformation, wie beispielsweise das letzte Signal, die Batterie- oder Signalstärke visuell dargestellt werden.

Unser Partnerunternehmen WSN Technologies AG erklärte sich dieses Jahr wiederholt dazu bereit, die benötigte Hardware in Form von Sensoren bereitzustellen. Vielen Dank! Neben Inwerken bieten sich auch Unternehmen wie Microsoft, John Deere oder IBM bei den Capstone Projekten als Sponsoren an. Anschließend suchen sich die Studierenden ihren Favoriten selbst aus.

Kommunikation – trotz Zeitunterschied kein Problem im NDSU Projekt

North Dakota und Deutschland trennen 7000 Kilometer. Damit haben wir eine zeitliche Differenz von 7 Stunden. Kein Problem für unsere Kommunikation, denn100 % der Kommunikation erfolgt mit Hilfe des Tools „Microsoft Teams“. Dazu zählt der Dokumentenaustausch, Status Updates mit Kanban Board, 24-Stunden-Chat sowie wöchentliche Video-Meetings.

Für die Studierenden ist das Projekt der Praxisteil ihrer Abschlussprüfung, während Inwerken von neuen innovativen Produkten und Features profitiert. Dabei lernen beide Seiten durch die jeweiligen und einzigartigen Projekterfahrungen dazu. Zu den Herausforderungen zählen bspw. die zeitliche Differenz aber auch kulturelle Unterschiede.

Kombination: Mixed-Reality & eKanban

Mixed-Reality ist die Erweiterung und Ergänzung des menschlichen Wahrnehmungs-Systems durch technisch gestützte Informationsaufbereitung. In dem aktuellen Projekt gilt es, Industrial IoT in Form von eKanban mit Hilfe von Mixed-Reality zu verbessern und damit moderne Produktionsproblematiken auszuhebeln.

Einsatzszenario A: Um einem Mitarbeiter in einer weitläufigen Logistikhalle die Navigation zu erleichtern, wird das nachzufüllende Regal zunächst lokalisiert. Anschließend bekommt er per Mixed Reality Brille Navigationsanweisungen sowie die momentanen Füllstände der Regale mitgeteilt.

Einsatzszenario B: Ein Techniker kann durch die Brille Telemetriedaten der Sensoren einsehen. Daher weiß er, wann die Batterien leer sind, ob es Signalprobleme gibt oder der Sensor einen Defekt aufweist.

Die Studierenden arbeiten zu fünft effektiv und stets motiviert an einer Lösung. Dafür haben sie sich in zwei Teams aufgeteilt. Team A beschäftigt das User Interface und Team B die sogenannten AR-Marker – damit werden die Sensoren erkannt wie bspw. Produkte mittels Barcodes in einem Supermarkt.

Das „Marker-System“

Wie in einem Supermarkt jedes Produkt einen einzigartigen Barcode erhält, benötigt das auch jeder Sensor in einer Logistikhalle. Doch aufgrund technischer Variablen gestaltet sich die Art und Anzahl der verfügbaren Marker dynamisch. Je nach Höhe der Regale müssen die Marker eine bestimmte Größe besitzen oder die Kamera des Endgerätes eine entsprechende Auflösung, um sie als AR Objekt zu erkennen.

Das MR-Interface

Da unsere Applikation auch für die Nutzung von MR-Brillen ausgelegt sein soll, stand die Frage im Raum, wie sie bedient werden kann. Eine zusätzliche Fernbedienung wäre wenig sinnvoll, da dem Techniker somit nur noch eine Hand zur Verfügung stünde. Deshalb haben wir das Problem mittels „Virtual Buttons“ gelöst. Das bedeutet echte Gegenstände oder auch virtuelle Knöpfe, werden von dem Techniker mit dem Finger berührt und agieren dann wie Knöpfe, um das Interface zu steuern.

Wie profitieren Unternehmen von dieser Lösung?

Unternehmen profitieren schnell von der Integration, denn der Informationsfluss wird beschleunigt. Ob mit Tablets, Smartphones oder Brillen – Ein Techniker muss sich die Informationen nicht vor der Arbeit beschaffen, sondern kann direkt loslegen. Die Daten werden ihm dann bereitgestellt, wenn er sie wirklich braucht. Zudem finden sich Fabrikmitarbeiter besser zurecht. Fehlerquoten werden reduziert. Niemand muss mehr auf die Suche gehen, um bestimmte Nachfüllaufträge auszuführen, sondern bekommt die Daten direkt in das Sichtfeld projiziert.

Sobald Mixed-Reality zum Arbeitsalltag gehört, wird sich auch die Frage stellen, wie schnell die Integration in bestehende Systeme zu realisieren ist. Bevor man dies mit derzeit noch teuren MR-Brillen umsetzt, können auch Tablets und Alternativ-Lösungen in Frage kommen.

Aktueller Stand & Mid-Terms-Präsentation

Vor Kurzem hielten die Studenten ihre Mid-Term Präsentation. Diese findet immer zur Halbzeit des Projekts statt und war dieses Jahr sehr erfolgreich:

Wir sind vom bisherigen Verlauf des Projektes begeistert und freuen uns auf das Ergebnis. Dabei können wir uns bereits zahlreiche Einsatz-Szenarien vorstellen.

Wer sich für weitere Projekte mit der NDSU interessiert, wird in unserem Expertblog fündig. Das Thema letztes Jahr: IoT – Plug-and-Play